File - настройка и указанията забрани индексирането на страници

Robots.txt - Тази услуга файл, който служи като препоръка за ограничаване на достъпа до съдържанието на уеб документи за търсачките. В тази статия, ние ще обсъдим създаването Robots.txt, описание и създаване на насоки за своята популярна CMS.

Защо ми е необходим robots.txt

Както споменах по-горе - чрез файла robots.txt, ние може да ограничи достъпа на роботите на търсещите машини за документите, т.е. ние се отразява пряко върху индексирането на сайта. Най-често затворен от индексиране:

- Официални файлове и папки, CMS

- дубликати

- Документите, които не носят ползи за потребителя

- Не отделни страници

Нека разгледаме конкретен пример:

Онлайн магазин за обувки и реализира един от най-популярните CMS, което не е най-добрият начин. Мога да кажа веднага, че ще издаде страница за търсене, страниране, пазарска количка, някои курсора на файлове и т.н. Всичко това ще бъде двойни и файлове за услуги, които са безполезни за потребителя. Следователно, те трябва да бъдат покрити от индексация, а ако все още има раздел "Новини" в копиране и поставяне, са различни интересни статии към сайтове на конкуренти - и след това мисля, че не е необходимо, просто затвори.

Robots.txt директиви и правила за конфигуриране

Потребителят-агент. Този призив към конкретна робот търсачката или на всички роботи. Ако предписаното конкретното име на робота, например «YandexMedia», общата директиви потребителския агент не се използват за това. Пример за писане:

Забрани / Разреши. Тя деактивирате / активирате индексиране на даден документ или секция. Редът на писане не е от значение, но 2 от директивата и при същия префикс, се дава приоритет на «Разреши». Чете робота тяхната дължина префикс, от най-малкия до най-големия. Ако имате нужда, за да забраните индексирането на страницата - просто вход относителния път към нея (Disallow: / блог / пост-1).

Регулярните изрази * и $. Звездичката означава всяка последователност от символи (включително празно). знакът за долар означава прекъсване. Примери за приложение:

Карта на сайта директива. Ако използвате (sitemap.xml) Картата на сайта - тогава си го robots.txt следва да се посочи, както следва:

Директива домакин. Както знаете сайта има огледало (за да прочетете как да се залепи сайта на огледало). Това правило определя робота за търсене на главното огледало на живота си. Той се позовава на Яндекс. Ако имате огледало без WWW, пишем:

Пълзи-закъснение. Определя задържат (в секунди) между скокове бот на Вашите документи. Предписани след директивата Забрана / Разрешаване.

Clean-Парам. В него се посочва робот за търсене, което не трябва да изтеглите допълнителна информация дубликат (идентификатори на сесии, препращащ потребител). Предписват Clean-Парам трябва да бъде динамични страници:

Основното правило: robots.txt трябва да бъдат написани с малки букви и лъжа в основата на сайта. Пример файлова структура:

Мета маркер за роботи и как той е предписан

Тази опция се взема предвид забраната на страниците по-добре на търсачката на Google. Yandex еднакво добре да вземе предвид и двете.

За всяка една страница, можете да се регистрирате в маркера

следното:Правилни robots.txt файлове за популярна CMS

Robots.txt пример за WordPress

По-долу можете да видите моята версия на блог Seo.

Utilities папка и файлове от всякакъв CMS се опитвам да затворя, защото Аз не искам от тях да попадне в индекса (въпреки че търсачките вече, и така не приемайте, но тя няма да бъде по-лошо).

Фураж (фуражи) е затворен, тъй Това частично или пълно дубликати страници.

Tags затворят, ако ние не използваме или мързел ние ги оптимизира.

Примери за други CMS

За да изтеглите правилните роботи за дясното CMS, просто кликнете върху съответната връзка.

Как да се провери коректността на операцията на файла

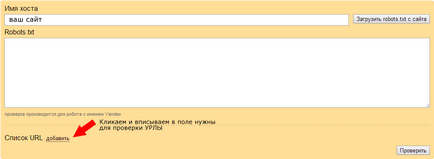

Анализ на файла robots.txt в Yandex Webmaster - тук.

Следим и коригира, ако е необходимо.

Популярни въпроси за robots.txt

Как да се затвори сайта индексирането?

Как да се предпазим индексиране на страницата?

Как да предотвратя индексиране огледало?

За да съхраните затваряне разходи количка (кошница)?

Имам един сайт без CMS, дали имам нужда от роботи?

- Да, за да се уточни домакин и Sitemap. Ако имате дубликати - че въз основа на ситуацията ги затвори.

Друг въпрос, който не може да намери отговора. Ще Ви бъда благодарен за вашето мнение. Позволете ми да ви напомня, че в сайта ми - не е блог, а на мястото на малка агенция за недвижими имоти.

Сайт на WordPress, коригиран роботите в съответствие с препоръките и примерите на различни сайтове. Заедно с други директиви и те са:

Disallow: / WP-включва /

Disallow: / WP-съдържание / плъгини /

Disallow: / WP-съдържание / теми /

Проверете моите страници в уеб администратори на Google, вижте "Преглед като Googlebot». С това robors страници се показва само текст, а именно, че той изглежда почти като плат. Снимка, дизайн, дизайнерски елементи, таблици и т.н. не се вижда. Това показва, че блокирането на тези елементи се дължи на следните директиви:

Disallow: / WP-включва /

Disallow: / WP-съдържание / плъгини /

Disallow: / WP-съдържание / теми /

В този контекст на въпроса. Тя трябва да бъде така, че сайтът изглежда като пресечена за търсачките? Или е тя да бъде понижена в резултатите на търсачките се дължи на факта, че тя изглежда в очите им недостатъци? Ако последното е вярно, тогава какво трябва да се направи, за да възстановят положението?

Сергей К. добавите роботи:

Позволете: / WP-съдържание / качвания / * / * /

Останалата част - СС не изглеждаше на мястото, както обикновените потребители.

Благодаря ви много, римски, които са отговорили на молбата ми. И аз ще направя като ви посъветва.

Благодарим ви за информационен статия. Сега знам, че моето място е направил грешен файл robots.txt. Затова, моля се изясни следното:

Ако е необходимо, кои от тях?

Благодаря предварително.